Este artículo se publicó hace 5 años.

TecnologíaInteligencia artificial para hacer el bien

El desarrollo tecnológico nos está planteando retos para los que nuestros sistemas —económicos, jurídicos e incluso éticos— no parecen estar suficientemente preparados. Ahora, un observatorio "independiente" promete trabajar para fomentar su uso "para el bien social".

Madrid--Actualizado a

¿Qué esperamos de la inteligencia artificial, cada vez más presente en nuestra vida? Y lo que es más importante, ¿qué tipo de decisiones puede llegar a tomar una persona basándose en las respuestas de un algoritmo, o incluso un sistema autónomo? Estas y otras muchas preguntas se plantean los responsables de poner en marcha OdiseIA, una plataforma que busca convertirse en referente en España para el análisis del impacto de la inteligencia artificial.

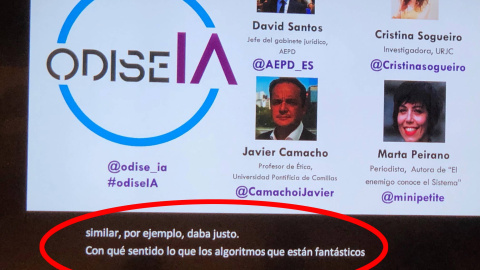

Esta iniciativa, de la que sus responsables subrayan su "independencia", ha celebrado su presentación en el auditorio de Google Campus en Madrid, y aspira a ser un espacio "de pensamiento y de acción". "Queremos fomentar el buen uso y las ventajas de esta tecnología", explicó a Público Idoia Salazar, investigadora en la Universidad Ceu San Pablo y miembro fundador de OdiseIA.

Parte de la acción que desarrollarán tendrá forma de lobby. "Nuestra idea es seguir de consejo para gobiernos e instituciones públicas y privadas, a los que aportaremos nuestras investigaciones para que les permitan encontrar un balance entre el avance tecnológico y la seguridad de los ciudadanos".

Durante su presentación tuvo lugar una interesante mesa redonda en la que algunos expertos mostraron la complejidad del asunto y sus contradicciones.

Moderados por la periodista Mar Cabra —también miembro del equipo fundador de OdiseIA—, dos ingenieros, una periodista y un jurista fueron desgranando algunos de los puntos más interesantes sobre los que cabe profundizar.

"Responsabilidad de todos"

"Me preocupa el combustible de la inteligencia artificial, que son los datos de carácter personal", expuso David Santos, jefe del gabinete jurídico de la Agencia Española de Protección de Datos (AEPD), para quien "el principal problema detectado es el desconocimiento de los usuarios". "La ética es una responsabilidad de todos", remarcó.

Sin embargo, la periodista e investigadora Marta Peirano no ve apropiado culpar a los usuarios, y recordó que sólo en los últimos dos años nos hemos enterado de la extracción masiva de datos sin permiso que hemos sufrido los usuarios de plataformas como Facebook o Google.

"El problema, por ejemplo, en los datos médicos —hay 56 leyes distintas en Europa— es que hay países que entregan esos datos sin permisos a empresas como Google", sostuvo la autora de 'El enemigo conoce el sistema' (2019). Además, cree que no se está aplicando el Reglamento General de Protección de Datos (RGPD) correctamente porque las empresas son demasiado opacas.

Cristina Soguero, investigadora de la Universidad Juan Carlos I especializada en inteligencia artificial aplicada a la salud, planteó precisamente la falta de control de los datos en un contexto en el que hay empresas de EEUU que están comprando datos de España.

"Primero tenemos que tener los medios para conocer esas actividades, ya que muchas veces las agencias de protección de datos no llegan", puntualizó Santos, que reconoce que a menudo la sociedad se entera de lo que sucede en el seno de las grandes tecnológicas gracias a denunciantes, empleados de empresas y periodistas que realizan su trabajo de investigación.

Para Javier Camacho, profesor de ética en la Universidad Pontificia de Comillas, la ética es en general "una sutil escala de grises" y en relación con la inteligencia artificial tiene que ser visto "como un concepto dinámico, como un proceso de diálogo multidisplicinar, y no dejarlo en manos de unos técnicos que consideren qué es justo y qué no". Para este profesor “la ética va por delante de la normativa, va desbrozando el camino”.

"Si la AI tiene como centro el ser humano, tiene que respetar los derechos fundamentales desde el diseño", apuntó Santos, quien además recordó algunas de las cuestiones de muestran la complejidad del asunto: "La inteligencia artificial se alimenta de datos pero puede crear —y crea— nuevos datos, y a través de éstos (o del uso de los metadatos) se puede inferir la religión o la tendencia sexual de alguien", recordó.

Transparencia y algo más

¿Deberíamos exigir más transparencia tanto a empresas como a administraciones públicas? es decir, ¿es la transparencia —el acceso a los algoritmos para saber cómo funcionan y para qué sirven realmente— una condición para el desarrollo ético de estas tecnologías? Para Santos, "la principal tarea desde lo público es la creación de una cultura de privacidad y que exija más transparencia a esas empresas".

También Peirano opina que "lo más ético que podemos pedir a la inteligencia artificial es la transparencia". "Sin ese conocimiento (como son, cómo funcionan, a quién sirven), sin poder auditarlos, la lucha por la libertad y los derechos es estéril", subrayó, y agrego: "Muy pocos conocen cómo funcionan los algoritmos, y muchas personas se ven afectadas por ellos, porque ni siquiera conocen sus fines; delegamos algunas decisiones en algoritmos opacos a los que suponemos objetividad, y el resultado es discriminatorio".

Soguero, quien también replicó que muchos de los avances en la materia son transparentes, al menos académicamente: "Cada vez más publicamos en código abierto para ser auditado".

Al final, Camacho concluyó expresando que para él el principal riesgo es centrarse "en el pequeño debate de la trasparencia y perder de vista el panorama general, que es bajo qué aspectos se puede perder el control del sistema de inteligencia artificial". Y sugiere, en cualquier caso, recordar el viejo dicho que invita a una reflexión sosegada: "No todo lo que se puede hacer se debe hacer".

Comentarios de nuestros suscriptores/as

¿Quieres comentar?Para ver los comentarios de nuestros suscriptores y suscriptoras, primero tienes que iniciar sesión o registrarte.